L’univers de l’IA évolue à grande vitesse : d’un côté, les modèles de langage (LLMs) progressent et savent générer du contenu de plus en plus pertinent ; de l’autre, les besoins des entreprises exigent une intégration toujours plus fluide avec leurs outils et données.

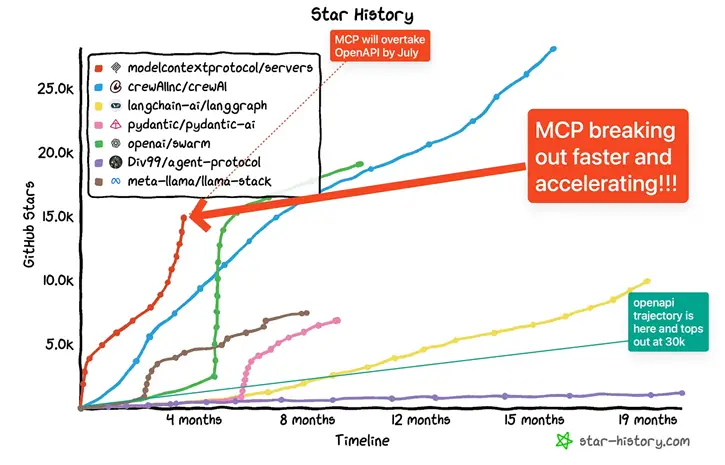

C’est dans ce contexte que MCP (Model Context Protocol) s’impose aujourd’hui comme un standard ouvert pour connecter les assistants d’IA aux services et sources d’information du monde réel.Cet article vous propose de découvrir pourquoi le protocole MCP est en train de changer la donne, comment il fonctionne à grands traits, et quels usages concrets il permet déjà d’imaginer.

Qu’est-ce que le Model Context Protocol (MCP) ?

Le Model Context Protocol, introduit par Anthropic fin 2024, définit une façon standard pour un assistant IA de se connecter à des ressources externes (bases de données, applications métier, outils de messagerie, etc.).

Le but :

- Eviter de développer des connecteurs “maison” pour chaque service.

- Permettre à l’IA d’accéder à des données à jour ou d’effectuer des actions concrètes (créer un ticket, envoyer un message…) via des services exposés de manière unifiée. E

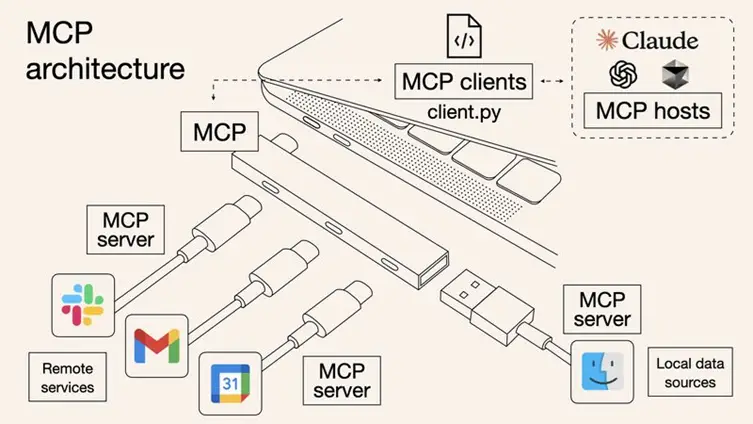

En clair, MCP agit comme un “port USB” pour l’IA : on branche un “serveur MCP” à l’assistant, et ce dernier sait immédiatement quels types d’actions ou de contenus il peut exploiter, sans avoir à coder d’intégration spécifique à chaque fois.

Pourquoi un tel protocole ?

1. Briser la fragmentation

Historiquement, même un LLM avancé restait enfermé dans sa bulle : il ne connaissait que son propre entraînement (souvent figé) et ne pouvait pas interagir en direct avec des services ou des données à jour. Pour chaque source (CRM, calendrier, base de connaissance…), on devait développer un connecteur ad hoc, ce qui était lourd et peu évolutif.

Avec MCP, on unifie cette approche : l’IA découvre un serveur MCP disponible et sait immédiatement quelles actions ou quelles données sont proposées, via un langage commun.

2. Des IA vraiment utiles et contextuelles

Les IA deviennent plus performantes quand elles accèdent à du concret :

- Infos d’entreprise (wiki, tickets, documents internes)

- Données en temps réel (prix, inventaire, météo, logs d’erreurs)

- Systèmes d’actions (envoyer un message Slack, programmer un rendez-vous…)

MCP servers permettent de “brancher” ces flux de données et d’outils sans recoder chaque intégration. L’IA gagne en pertinence et en capacité d’action.

3. Standardiser la sécurité et la gouvernance

Dans un contexte professionnel, on ne veut pas donner carte blanche à l’IA. Or, MCP a été pensé pour séparer la logique AI (MCP host) de la logique d’accès (serveur MCP) :

- Les clés API ou accès sensibles restent côté serveur

- L’utilisateur peut approuver ou refuser les opérations à risque

- Les journaux d’activité (logs) permettent de tracer tout ce que fait l’IA

Résultat : on obtient une gouvernance centralisée et moins de risques de fuite de données, contrairement à des intégrations maison où l’on exposait parfois les identifiants de manière hasardeuse.

Architecture simplifiée

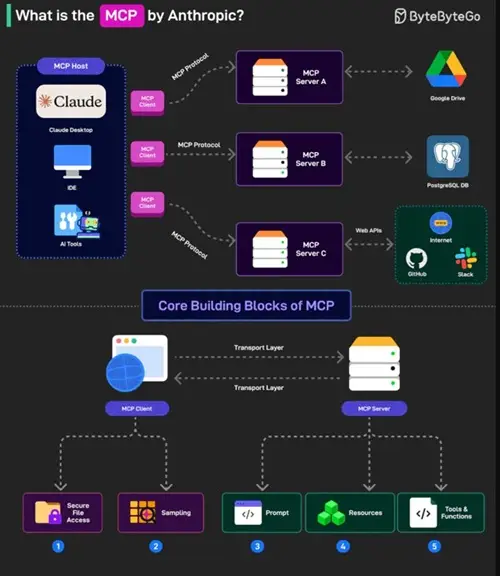

Sur le plan technique, MCP fonctionne en mode client-serveur :

Le client MCP est intégré dans l’application d’IA (par ex. Claude Desktop, une extension VS Code ou Cursor,…). C’est lui qui reçoit les consignes de l’utilisateur.

Les serveurs MCP sont des processus (locaux ou distants) qui exposent :

- Des ressources (documents, données, historiques, etc.)

- Des outils (fonctions pour interagir avec des applis, naviguer, poster des messages).

- Des prompts ou “modèles de requêtes” (pour guider l’IA dans certaines tâches spécialisées)

Le protocole définit comment le client et le serveur dialoguent : les requêtes (lire tel document, appeler telle fonction…) et les réponses (données brutes, résultats d’API, etc.) suivent un format unique, s’appuyant sur des standards comme JSON-RPC.

Pour l’utilisateur final, tout se fait en coulisses. Il voit simplement que son assistant IA peut “aller chercher” des informations ou déclencher des actions de façon fluide, sans multiples configurations manuelles.

Lorsqu’on connecte plusieurs serveurs MCP à un même IA host, on obtient un hub d’intégrations :

Exemple : un assistant IA en entreprise peut à la fois appeler :

- Un serveur MCP “Google Drive” (pour récupérer un fichier)

- Un serveur MCP “Git” (pour lire du code ou créer une branche)

- Un serveur MCP “Slack” (pour envoyer un message d’alerte)

- Et ainsi de suite…

Cas d’usages concrets

1. Collaboration et data d’entreprise

- Slack + Google Drive + Atlassian : L’IA retrouve un document dans Drive, vérifie des tickets Jira, et résume une conversation Slack pour l’équipe. Tout passe par des MCP servers déjà disponibles (souvent open source) ou proposés officiellement (ex. Atlassian MCP server pour Jira/Confluence).

- Confluence interne + bases SQL : L’assistant puise dans la doc de l’entreprise et réalise des requêtes sur une base de données en temps réel pour fournir des réponses pertinentes.

2. Développement et DevOps

- GitHub MCP : L’IA peut chercher un fichier précis, proposer un commit message, ou créer une Pull Request.

- Puppeteer MCP : L’IA contrôle un navigateur headless, exécute des tests end-to-end, remonte les logs d’erreurs.

3. Recherche et veille

- ArXiv MCP : l’IA interroge la plateforme pour trouver les derniers articles sur un sujet de recherche.

- Brave Search ou Google News MCP : l’agent peut faire des recherches web actualisées pour combler ses lacunes dans le temps.

4. Assistant personnel ou automation grand public

- Calendrier : proposer un créneau pour un rendez-vous, puis envoyer l’invitation mail.

- Applications locales : un serveur MCP “File system” peut lister ou ouvrir certains documents, tant que l’utilisateur l’autorise.

MCP vs. intégrations IA traditionnelles

Standard unique vs. intégrations sur-mesure : auparavant, chaque fois que vous vouliez que l’IA accède à un nouveau service, il fallait recréer un connecteur avec des API spécifiques. MCP balaie ce problème en proposant un cadre universel. Une fois qu’un IA host supporte MCP, il peut se connecter à tout serveur MCP.

Données fraîches et interaction bidirectionnelle : dans un système IA classique, le modèle reste passif : il ne peut que recevoir des prompts et y répondre. Ici, l’IA agit : elle peut faire des requêtes, déclencher des tâches… et recevoir du feedback en direct (avec l’accord de l’utilisateur).

Sécurité renforcée : avec MCP, les identifiants restent côté serveur ; l’IA ne voit jamais les clés API ou mots de passe. Les actions sont validées, et un mode “local-first” limite les risques.

Développement facilité : pour le développeur, c’est un gain de temps : plus besoin de gérer N connecteurs distincts. Il suffit de bâtir un serveur MCP (souvent en quelques lignes de Python, JavaScript ou autre) qui suit la spécification, ou de réutiliser les nombreux serveurs open source déjà disponibles.

Bénéfices pour les entreprises et les développeurs

- Interopérabilité : le même protocole dessert de multiples services. On réduit la complexité et on accélère les intégrations.

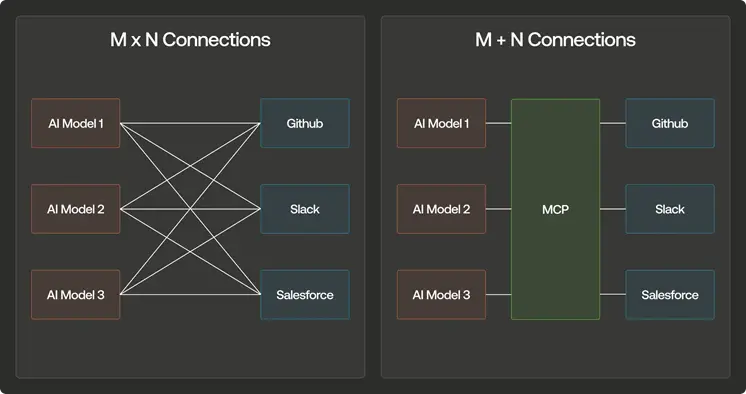

- Économie de maintenance : au lieu d’avoir M × N connexions à maintenir (M outils × N agents IA), on se retrouve avec un schéma centralisé : on implémente MCP une fois, et toute évolution profite à l’ensemble.

- Gouvernance claire : possibilité de filtrer les accès, de tracer les actions, de limiter les permissions par domaine (ex. lecture seule sur un dossier).

- Écosystème en expansion : chaque nouveau “bloc” (serveur MCP) devient immédiatement utilisable par tous les hôtes MCP. Cette effet de réseau stimule l’innovation.

Perspectives

- Agents IA plus “agentiques” : avec MCP, l’IA peut déjà enchaîner des actions complexes : consulter des logs, lancer un test, poster un message Slack, éditer un document… On se rapproche du rêve d’un assistant “Jarvis” qui orchestre plusieurs outils de manière fluide et cohérente.

- Vers un standard industriel : de nombreuses entreprises ont déjà annoncé leur support pour MCP. Tout indique que ce protocole pourrait devenir la référence pour relier IA et services métier, un peu comme REST ou GraphQL pour les APIs web.

- Gouvernance et sécurité avancées : au fil des retours d’expérience, on verra se perfectionner les mécanismes de contrôle d’accès, d’approbation et de logs unifiés. La montée en puissance de l’IA implique une supervision plus fine, et MCP offre une base solide pour concilier efficacité et conformité.

- Élargissement de l’écosystème : à mesure que la communauté développe de nouveaux serveurs MCP pour toutes sortes de services (ERP, marketing automation, 3D, etc.), l’intégration de l’IA dans notre quotidien deviendra de plus en plus aisée.

Conclusion

Les initiatives comme MCP démontrent un mouvement de fond : rendre les agents IA réellement polyvalents, connectés et capables de s’intégrer dans différents environnements. Nous ne sommes plus au stade de “juste” poser des questions à un LLM : l’IA peut désormais agir, interagir et orchestrer de multiples systèmes.

Dans cette dynamique, Google est également entré dans la danse avec Agent2Agent (A2A), un nouveau protocole ouvert visant à faciliter la communication entre agents de divers frameworks. A2A met l’accent sur la découverte des capacités de chaque agent (via les “Agent Cards”), la gestion de tâches et l’interopérabilité sécurisée : on retrouve la même volonté de standardiser, cette fois-ci pour l’échange entre agents. Que ce soit MCP pour la connexion à des outils externes ou A2A pour le dialogue inter-agents, les protocoles ouverts se multiplient et préfigurent une IA toujours plus “connectée”.

Prochainement, nous aborderons la façon de se lancer concrètement avec MCP !

Découvrez nos expertises IA et contactez nos experts pour échanger sur vos projets et besoins spécifiques.

Par Jérémy BRON, Directeur IA de Silamir Group